苹果展示 AI 新模型 MGIE,可一句话精修图片

IT之家 2 月 8 日消息,相比较微软的风生水起,苹果公司在 AI 领域的布局显得低调很多,但这并不意味着苹果在该领域就没有丝毫建树。苹果公司近日发布了名为“MGIE”的新型开源人工智能模型,它可以根据自然语言指令编辑图像。

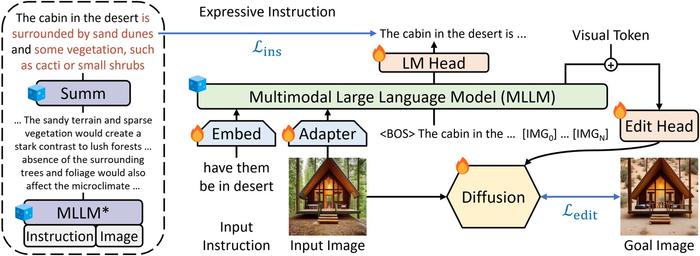

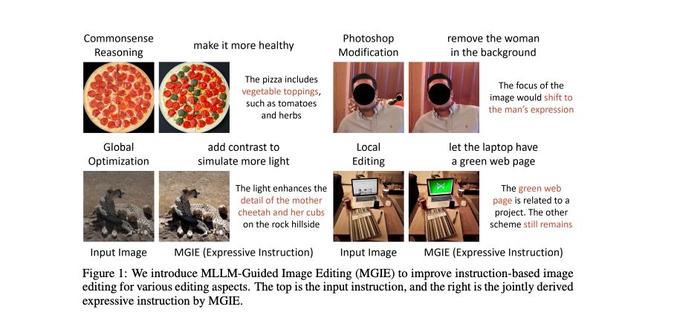

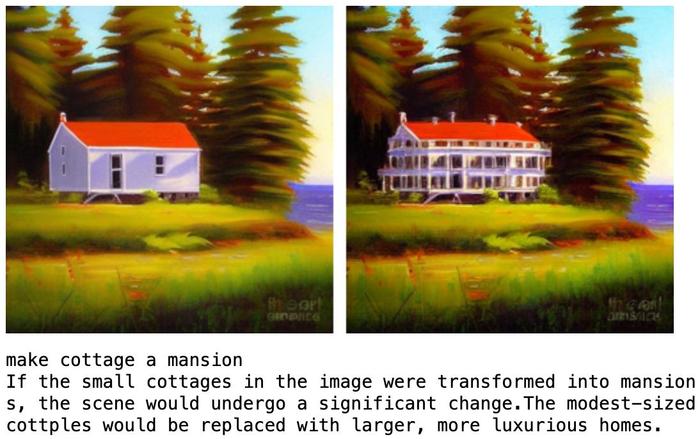

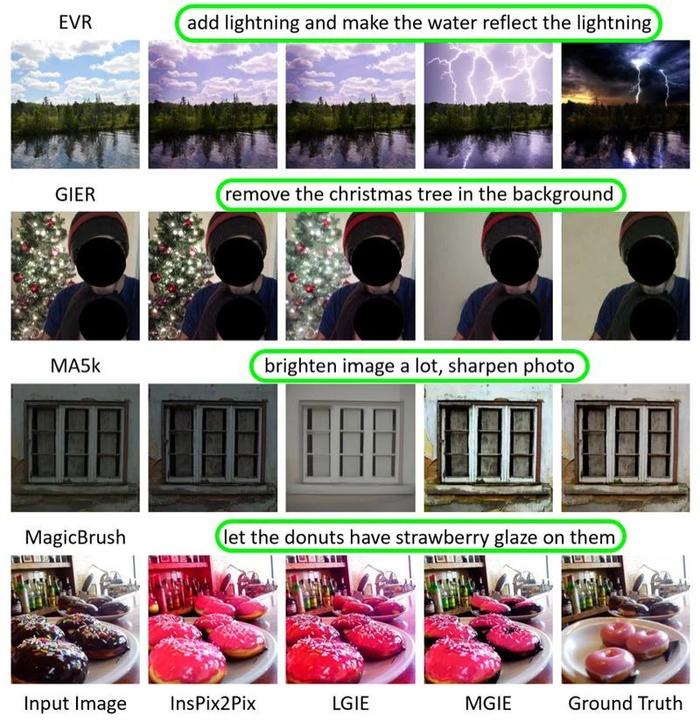

MGIE 的全称是 MLLM-Guided Image Editing,利用多模态大型语言模型(MLLM)解释用户指令并执行像素级操作。MGIE 可以理解用户下达的自然语言命令,进行 Photoshop 风格的修改、全局照片优化和局部编辑等操作。

苹果公司和加州大学圣巴巴拉分校研究人员合作,在 2024 年国际学习表征会议(ICLR)上发表 MGIE 相关研究成果,而 ICLR 是人工智能研究的顶级会议之一。

介绍 MGIE 之前,IT之家先来介绍下 MLLM。MLLM 是一种强大的人工智能模型,可以同时处理文本和图像,从而增强基于指令的图像编辑能力。MLLMs 在跨模态理解和视觉感知响应生成方面表现出卓越的能力,但尚未广泛应用于图像编辑任务。

MGIE 通过两种方式将 MLLMs 集成到图像编辑过程中:首先,它使用 MLLMs 从用户输入中推导出富有表现力的指令。这些指令简洁明了,为编辑过程提供了明确的指导。

例如,当输入“让天空更蓝”时,MGIE 可以生成“将天空区域的饱和度提高 20%”的指令。

其次,它使用 MLLM 生成视觉想象力,即所需编辑的潜在表征。这一表征捕捉了编辑的本质,可用于指导像素级操作。MGIE 采用了一种新颖的端到端训练方案,可联合优化指令推导、视觉想象和图像编辑模块。

MGIE 可以处理各种编辑情况,从简单的颜色调整到复杂的对象操作。该模型还可以根据用户的偏好执行全局和局部编辑。MGIE 的部分特性和功能包括:

MGIE 是 GitHub 上的一个开源项目,用户可以点击这里找到代码、数据和预训练模型。该项目还提供了一个演示笔记本,展示如何使用 MGIE 完成各种编辑任务。

广告声明:文内含有的对外跳转链接(包括不限于超链接、二维码、口令等形式),用于传递更多信息,节省甄选时间,结果仅供参考,IT之家所有文章均包含本声明。

版权声明

本文收集整理自网络,如有侵权,请联系删除。